이번 게시글에서는 2022년에 IEEE에 발표된 Learning From Imbalanced Data With Deep Density Hybrid Sampling 논문을 다뤄보겠습니다.

Abstract

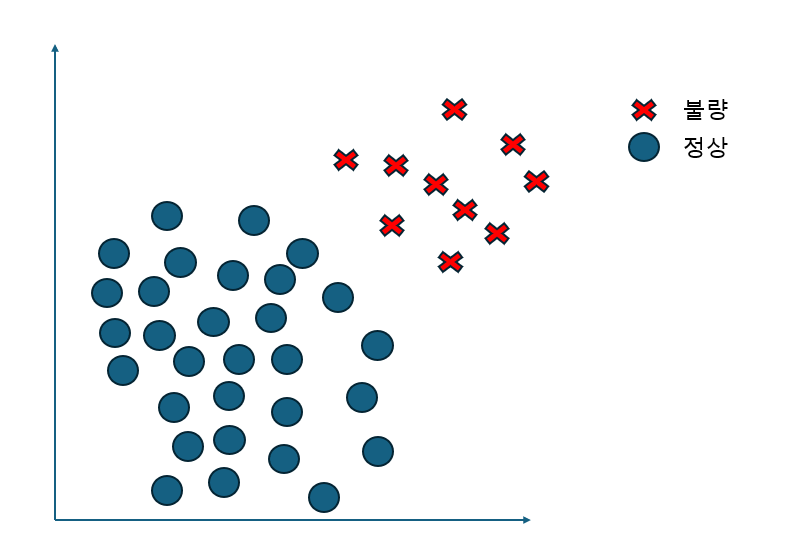

Imbalaced data 문제를 해결하기 위해서 많은 방법들이 있었는데, 대부분의 방법들은 오직 minority, majority class에 대해서만 고려하고 그 두개의 클래스 간의 관계에 대해서는 고려하지 않고 있습니다.

게다가 데이터 생성하는 많은 방법들이 original feaure space로부터 데이터를 생성하고 있으며 이때 Euclidean distance를 사용합니다(SMOTE처럼). 하지만, high dimensional space일수록 Euclidean distance는 더이상 중요한 거리가 되지 않습니다. 그래서 저자는 새로운 방법론인 DDHS(deep density hybrid sampling)방법을 소개하며 불균형 문제를 해결하고자 합니다.

저자가 기존의 방법론들과 어떻게 다르게 접근하여 불균형 문제를 해결했는지 살펴보도록 하겠습니다.

Proposed Method

많은 Data-level 방법들이 SMOTE를 응용한 방법이지만, 크게 2가지 문제를 가져온다고 합니다.

- 오직 MInority samples만 고려하고, Majority class가 가져오는 영향을 무시한다

- Nearest neighbors를 찾기 위해 Euclidean distance(SMOTE에선 이 거리를 사용함)를 사용하지만, high-dimensional datasets에서는 정확하게 측정할 수 없다.

이 문제를 해결하기 위해 저자는 어떻게 해결하려고 했는지 살펴보겠습니다.

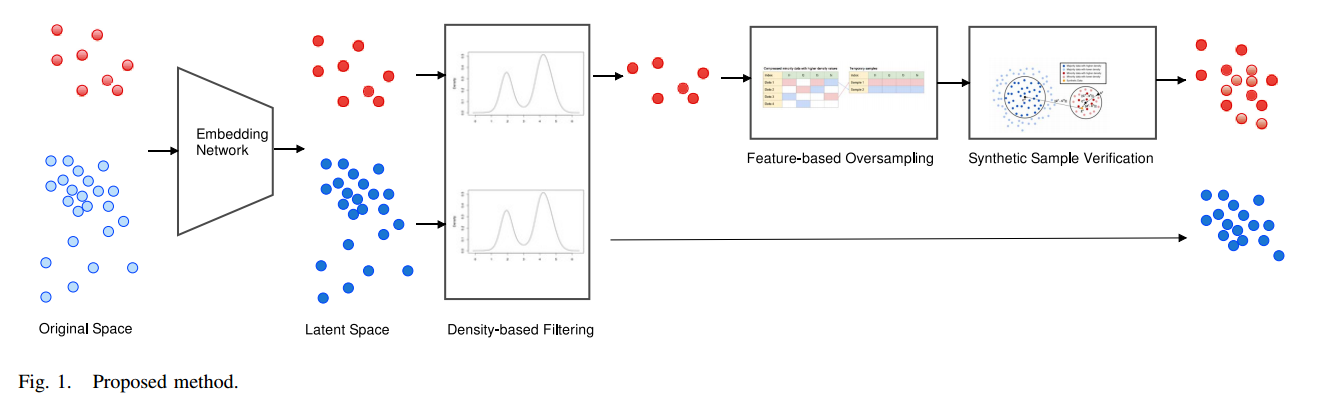

위 사진은 저자가 제안한 모델의 아키텍쳐입니다. 이 부분을 하나하나씩 살펴보도록 해서 어떻게 Oversampling, Undersamplilng을 수행했는지 확인해보도록 하겠습니다.

Notation

위 과정을 진행하기 전에 Notation에 대해 정의하고 수행하겠습니다.

$\{(x_i,y_i)^m_{i=1}\}, where \ x_i \in \mathbb{R}^D$

$x_i$ : feature vector

$y_i$ : corresponding label

$m$ : the number of training examples

$z_i$ : $x_i$에 의해 projection된 벡터 $z_i \in \mathbb{R}^d$

이때 d<D ($x_i$를 저차원 $z_i$로 사영시켰으므로 D가 d보다 큰것은 자명합니다.)

이 작업은 binary classification 작업에 초점이 맞춰져 있습니다.

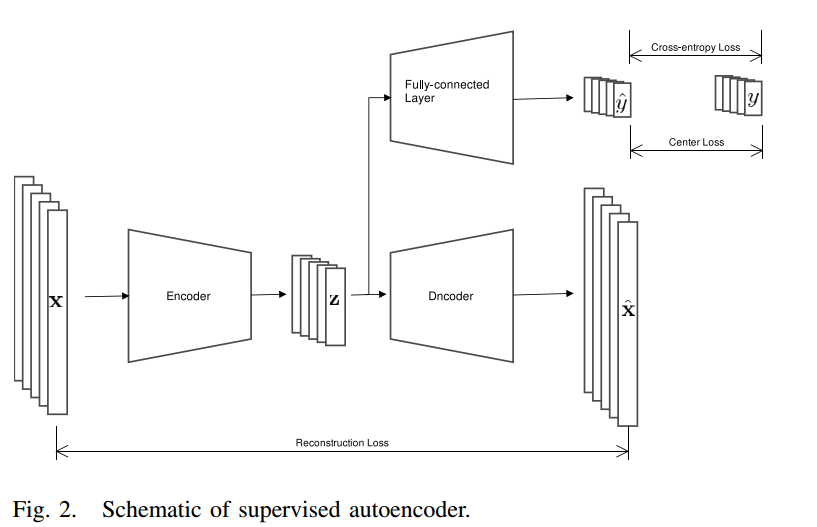

Embedding Network

저자는 제안된 방법을 develop하기 위해 autoencoder를 활용하였습니다.

Original autoencoder의 구조는

- Encoder

- 원본 데이터를 latent space으로 변환시키는 네트워크

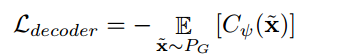

- Decoder

- latent vector들을 원본 데이터로 복원하는 네트워크

이렇게 2가지로 구성되어있습니다.

목표는 reconstruction loss를 최소화함으로써 Encoder와 Decoder를 동시에 최적화 하는 것입니다.

$x$ : 원본데이터

$D(E(x))$ : 원본데이터를 Encdoer를 통해 latent space로 축소시키고 다시 디코더를 통해 원본데이터의 차원으로 복원한 데이터

지도학습의 경우, 훈련 과정에서 레이블 정보를 활용하면 예측 성능을 향상시킬 수 있습니다. 이는 모델이 class 근접성을 유지하면서 동일한 클래스의 샘플들이 잠재 공간에서 더 가까워지도록 학습하는 데 도움이 됩니다. 따라서, 저자는 총 3가지 손실 함수를 사용하여 이러한 효과적인 학습을 달성하려고 합니다.

아래 그림은 저자가 제안한 방법의 아키텍쳐입니다.

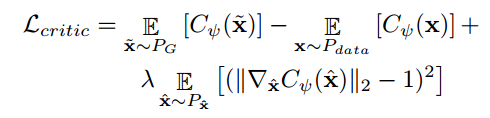

3가지 손실함수는 다음과 같습니다.

1. Reconsturction loss

- Autoencoder에 의해 계산이 되고, 이때 MSE(mean square error)를 사용하여 loss를 계산하게 됩니다.

$x_i$ : original data point(원본 데이터)

$\hat{x_i}$ : reconstructed data point(복원된 데이터)

$b$ : batch size(배치 사이즈)

실제 데이터와 Encoder, Decoder를 거쳐서 복원된 데이터간의 차이가 어느정도인지 MSE를 통해 계산되어 이 loss가 최소가 되도록 업데이트 됩니다.

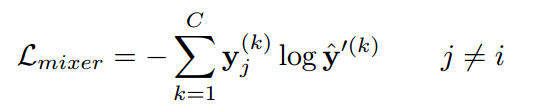

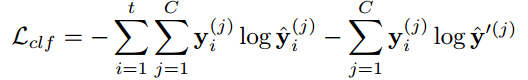

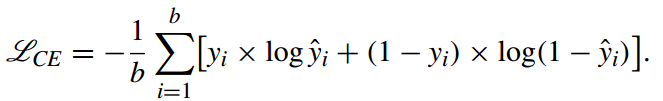

2. Cross-entropy loss

- 또한 저자는 Cross-entropy loss를 제안했는데, 레이블 정보를 활용하여 클래스가 다른 데이터들간의 거리는 멀게, 클래스가 같은 데이터들간의 거리는 가깝게 하는것이 목적입니다!

이렇게 loss를 설정함으로써 부정확한 클래스로 분류된 데이터에 대해서 패널티를 부과하여 loss를 계산하게 됩니다.

3. Center loss

- 마지막 손실함수는 Center loss함수입니다. 말 그래도 Class Center로부터 멀어질수록 패널티를 부여하게 됩니다. 그래서 이 loss를 통해서 같은 클래스들끼리 center로 향하도록 하는것이 목적입니다.

$c_{y_i}$ : latent space에서 $y_i$클래스의 center

$z_i$ : latent vector

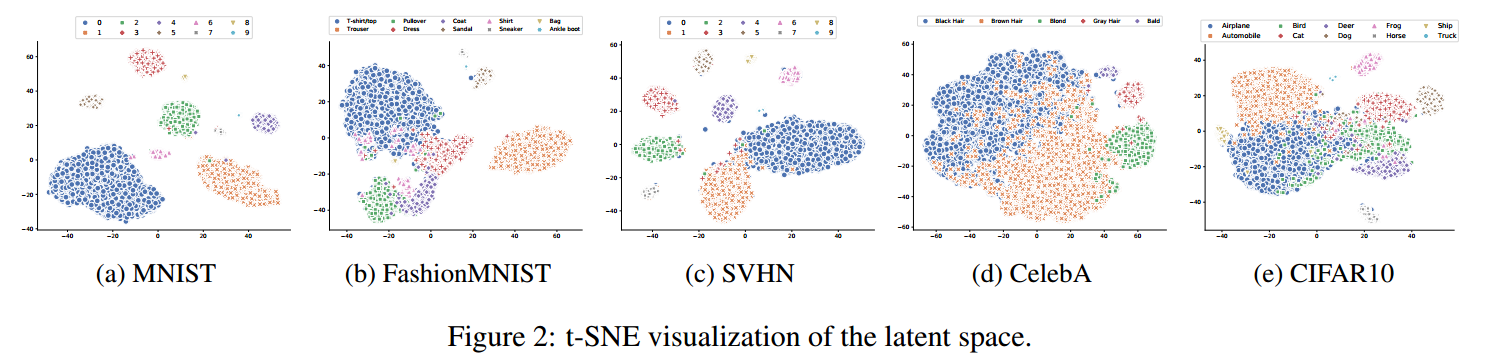

이 3가지 loss 함수를 통해서 projected data point들이 latent space에서 separable하게 하는 것이 목적입니다. latent space는 original feature space보다 저차원이기 때문에 high dimensional space에의해 발생되는 문제를 완화할 수 있습니다.

최종 loss는 다음과 같습니다.

Density-Based Filtering

Embedding network훈련 과정이 완료된 후 저자는 high-quality datapoint를 선택하기 위한 기준으로써 density를 사용합니다.

- Low-density data들은 다른 data point들과 멀이 떨어져 있기 때문에 noise가 될 수 있고,

- High-density data들은 cluster를 대표할 가능성이 큽니다.

저자는 이 part에서 high-density에 존재하는 data point에 대해 정의하고자 합니다.(어떤 기준으로 data가 high, low density에 속하는지)

저자는 latent space에서 데이터들의 density를 추정하기 위해 KDE(Kernel Density function)을 사용합니다. 그 중 Gaussian kernel을 사용하여 density를 추정하고자 합니다.

아래 링크는 kernel density function에 대해서 자세하게 다뤄주신 블로그 글입니다. 자세하게 설명해주셔서 궁금하신 분들은 확인해보시길 바랍니다!

https://darkpgmr.tistory.com/147

이제 density를 majority, minority class에 대해서 추정하려 합니다.

- Majority class

- majority density $Q_2$의 quartile보다 큰 data들만 유지시키도록 합니다.

- Minority class

- minority density $Q_3$의 quartile보다 큰 data들만 유지시키도록 합니다.

훈련 과정에서 데이터의 25%만을 유지하며 oversampling을 수행하지만, 나머지 75%의 데이터를 완전히 버리는 것은 아닙니다. 이 데이터는 나중에 classifier 훈련 과정에 포함될 예정이며, 특히 majority 데이터의 50%는 undersampling 과정에서 삭제됩니다.

이런 이유때문에 hybrid sampling인 것 같네요.

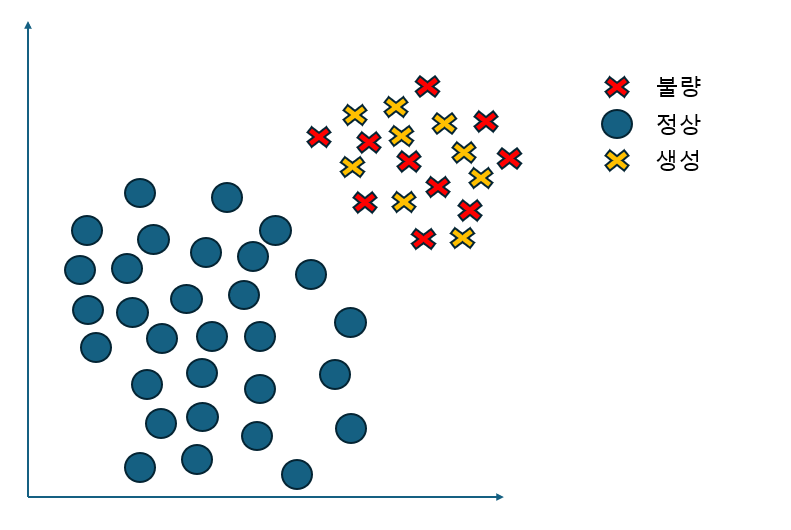

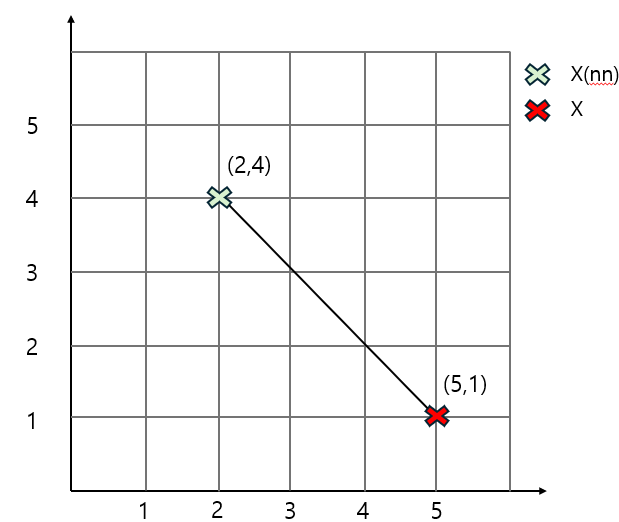

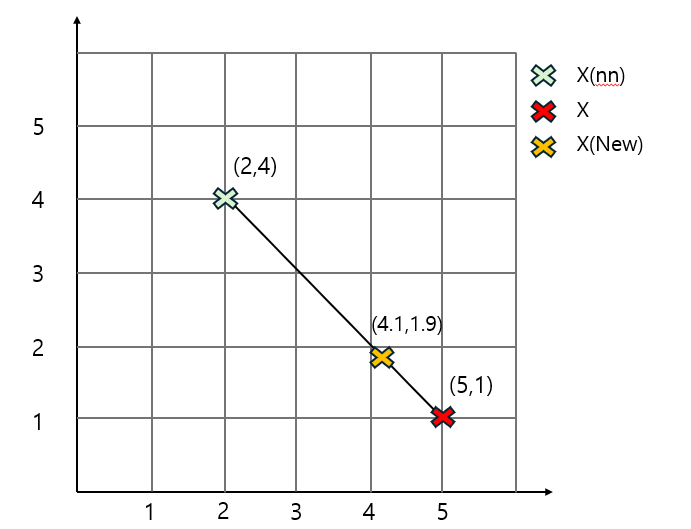

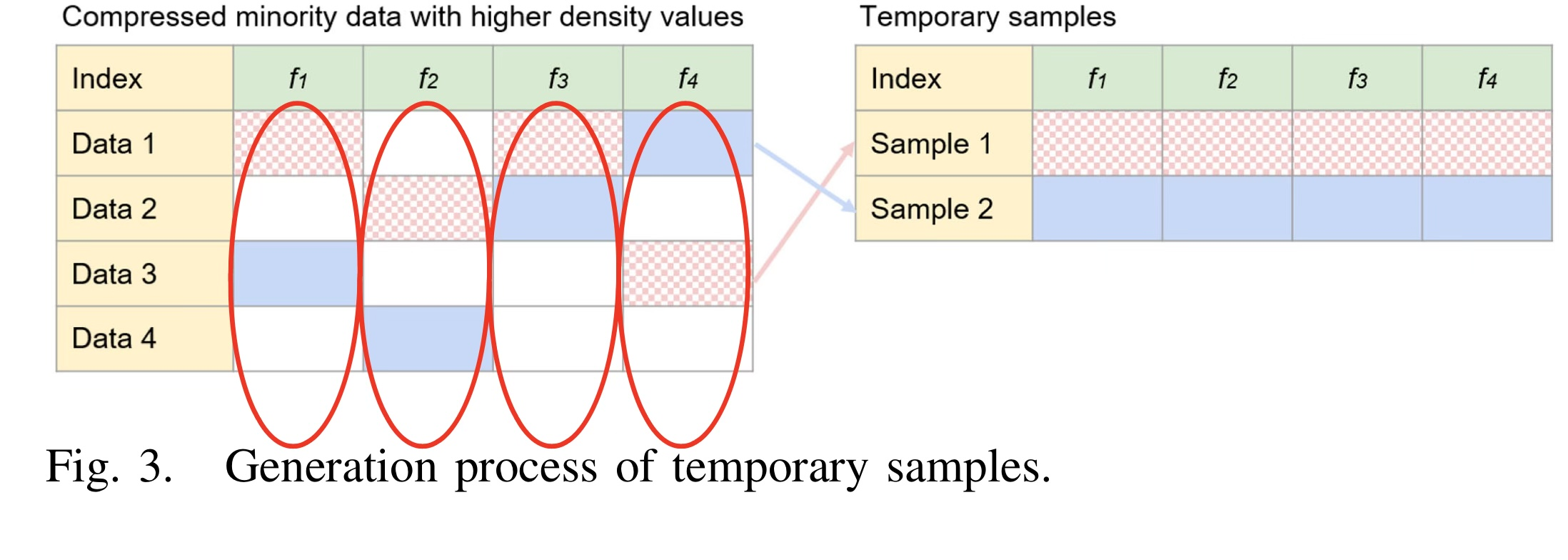

Generation of Synthetic Samples

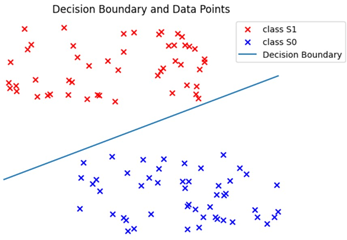

위 그림은 데이터 생성하는 방법입니다. Minority class를 oversampling 하는 법에 대해 설명하도록 하겠습니다.

아래 그림은 4개의 latent vector가 존재하고, 4개의 DATA가 존재한다고 가정하고 있습니다.

저자는 다양한 synthetic samples를 생성하기 위해 feature-level sampling 기법을 제안합니다.

위 그림을 예시로 들어서 설명하겠습니다. (latent feature은 4개)

Minority class에서 선택된 샘플들의 latent feature 집합 $V=[v_1,v_2,...,v_4]$이 주어지면, 각 feature의 value set이 정의됩니다.

- 먼저, 첫 번째 latent feature $v_1=[v_{11},v_{21},...,v_{41}]$(빨간색 원)에서 하나의 값을 무작위로 선택(복원 추출)하여 synthetic sample을 생성하기 시작합니다.

- 동일한 방식으로 나머지 feature2,3,4 들도 순차적으로 선택해 synthetic sample을 생성합니다.

랜덤한 process로 진행되기 때문에 생성되는 samples의 다양성을 높일 수 있습니다.

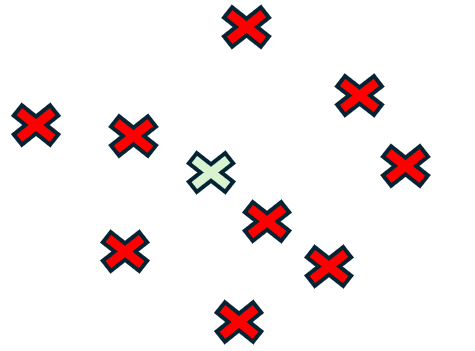

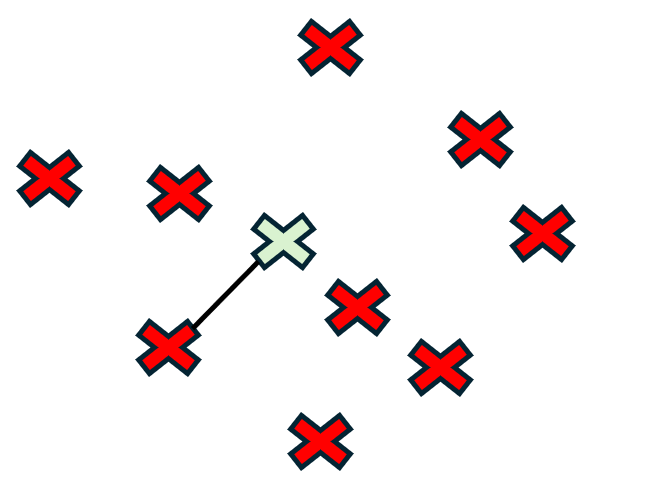

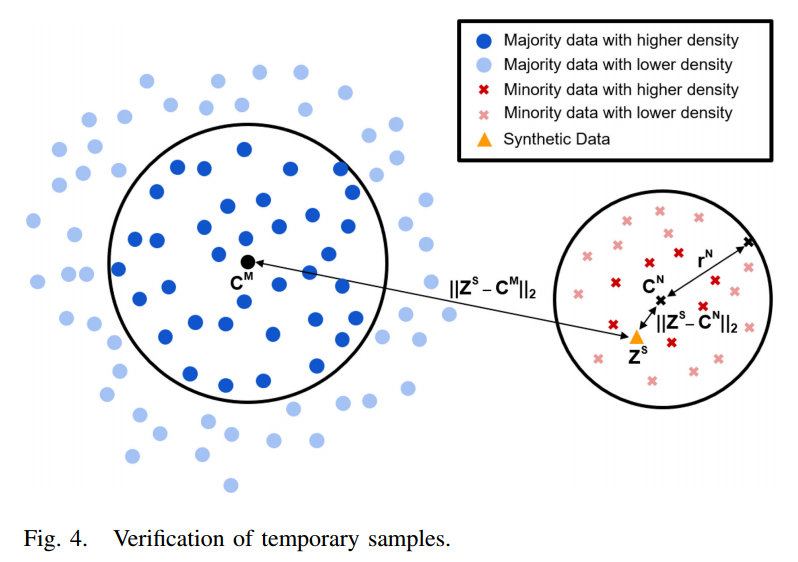

Verification of Synthetic Samples

Generation process가 완료되면, 생성된 샘플들이 좋은 퀄리티를 가지고 있는지 평가해볼 필요가 있습니다.

좋은 데이터가 생성됐는지에 대한 평가 기준은 density를 사용하게됩니다.

아래 사진은 각각에 대한 Notation입니다.

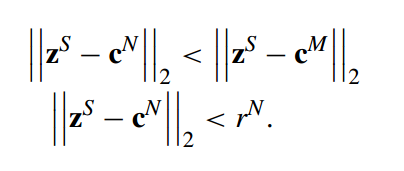

그리고 아래 사진에는 좋은 데이터가 생성됐는지에 대한 기준입니다.

위의 식을 보면 생성된 데이터가 Majority class의 center보다 Minority class의 center보다 가까운지 확인하는 것입니다. 즉, Minority class의 데이터를 oversampling 했으니 생성된 데이터는 Minority class의 center보다 가까워야겠죠? 그래서 저 조건이 성립해야 합니다.

또한 두번째 식을 보면 생성된 샘플과 Minority class의 거리가 center Minority class의 반지름보다 작아야 합니다. 조금 더 high-quality를 가진 샘플이 생성되어야한다는 조건을 추가로 만든 것 같습니다.

이렇게 두가지 식의 조건을 만족하면 좋은 퀄리티를 가진 데이터가 생성되었다고 볼 수 있습니다.(근데 사실 2번째 식만 만족하면, 첫번째 식은 자동으로 만족되는 것 같은데 굳이 첫번째 식이 필요한가?라고 생각해봤습니다….)

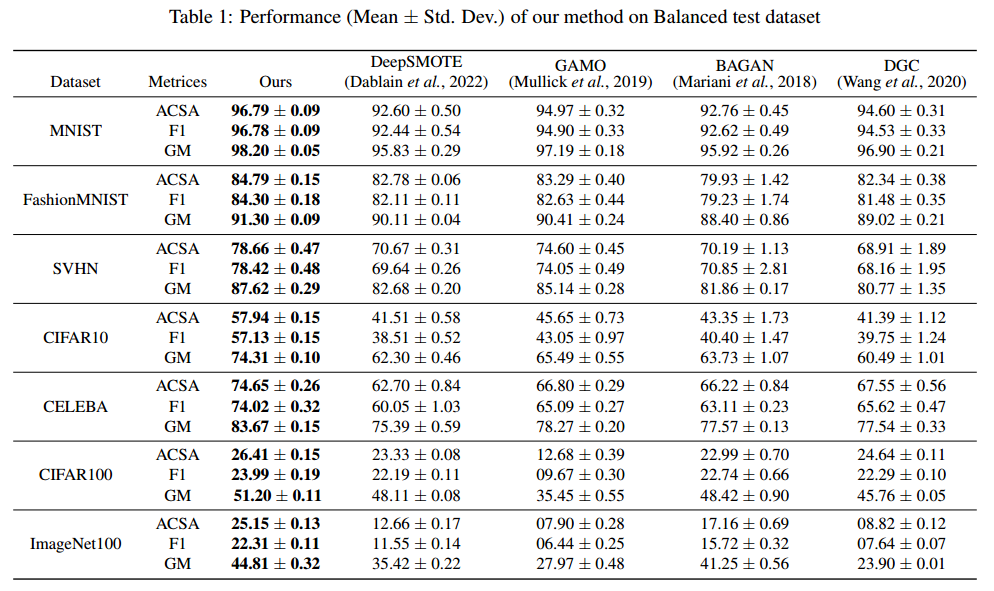

Experimental Results

저자가 데안한 모델을 다른 Data-level algorithm과 비교해서 성능이 어떤지 확인해보겠습니다.

Linear SVM을 사용하여 AUC와 AUPRC를 측정하였습니다.

- AUC

- AUPRC

저자가 제안한 모델이 대체적으로 좋은 성능을 가지는 것을 확인할 수 있습니다.

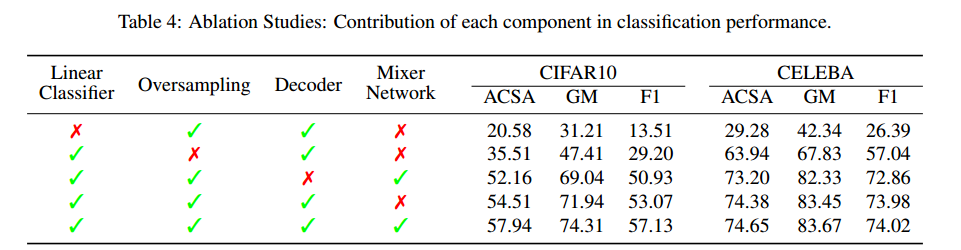

또한 Embedding Network에서 사용된 Loss functino에 대해서 Ablation studies를 진행한 결과입니다.

역시 3가지 loss를 사용하면 좋은 성능이 나타나는걸 확인할 수 있습니다

- cross-entropy loss가 분류기가 제대로 분류하면 loss가 작아지고, 못하면 loss가 커지기 때문에 만약 binary classification 에서 분류기가 분류를 더 잘한다면 더 좋은 성능을 가질 수 있지 않을까?라는 생각이 듭니다!

감사합니다.

참고문헌

'논문 리뷰 > Imbalanced data' 카테고리의 다른 글

| [논문리뷰] Minority Oversampling for Imbalanced Data via Class-Preserving Regularized Auto-Encoders (2) | 2024.09.21 |

|---|